localGPT是一个基于文档内容进行聊天对话的应用,它可以根据你提供的文档,利用Meta最新开源的大语言模型对文档内容进行分析总结,然后你可以围绕这些文档提出内容,localGPT会根据文档内容回答你的问题,本应用为免费开源应用,原项目地址:https://github.com/PromtEngineer/localGPT

localGPT特点

- 最高程度的隐私:您的数据保留在您的计算机上,确保 100% 的安全。

- 多种模型支持:无缝集成多种开源模型,包括HF、GPTQ、GGML和GGUF。

- 多样化的嵌入:从一系列开源嵌入中进行选择。

- 重复使用您的 LLM:下载后,可重复使用您的 LLM,无需重复下载。

- 聊天记录:记住您之前的对话(在会话中)。

- API:LocalGPT 有一个 API,您可以使用它来构建 RAG 应用程序。

- 图形界面:LocalGPT 带有两个 GUI,一个使用 API,另一个是独立的(基于 streamlit)。

- GPU、CPU 和 MPS 支持:开箱即用,支持多种平台,使用等

CUDA与您的数据聊天!CPUMPS

localGPT用法

我制作了最新版的一键启动整合包,下载链接见文章末尾。首先到网盘里将软件完整压缩包localGPT.7z下载到电脑上并解压,然后将你需要分析对话的文档复制到SOURCE_DOCUMENTS文件夹内,可以是一个文档也可以是多个,支持多种格式类型的文档,如:html,txt,md,py,pdf,csv,xls,xlsx,docx,doc,然后再双击运行【0分析文档内容.exe】,

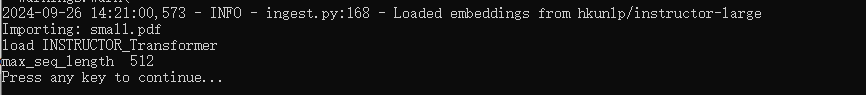

等到窗口输出importing:xxx文档名,Press any key to continue…等信息的时候就说明文档已经分析完成了,在DB文件夹内可以看到生成的文档相关的文件,然后再运行【1启动对话.exe】

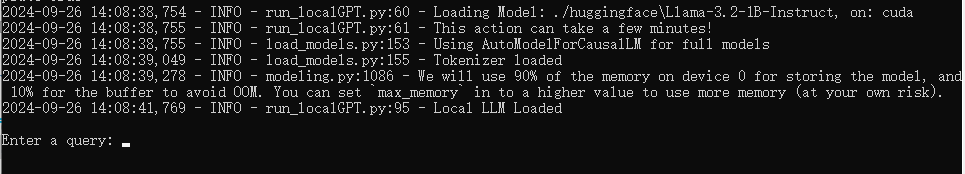

等到看到窗口输出Enter a query:的时候你就可以输入文字开始对话了,你可以询问任何关于文档内容的问题,可以输入英文也可以输入中文等,支持多种语言,可以进行连续对话。

由于使用GPU计算,对电脑显卡有要求,我默认使用的是Llama-3.2-1B-Instruct模型,Meta开源最新3.2版10亿参数的模型,如果你电脑显卡显存在8G以上的话,可以使用Meta-Llama-3-8B-Instruct模型,80亿参数模型更大,效果也更好,使用Meta-Llama-3-8B-Instruct模型的方法为:

在网盘里将这个模型压缩包下载到huggingface文件夹内并解压,然后打开constants.py文件,将第112行的代码MODEL_ID = os.path.join(MODELS_PATH, “Llama-3.2-1B-Instruct”)最前面添加一个“#”号将这行代码注释掉,然后将第111行的代码#MODEL_ID = os.path.join(MODELS_PATH, “Meta-Llama-3-8B-Instruct”)最前面的这个“#”删除掉,保存并关闭这个文件,然后重新运行分析文档和启动对话即可。

如果你的电脑配置更高,想要使用更大的模型的话,你可以到https://modelscope.cn/organization/LLM-Research?tab=model下载你想要的模型,放到huggingface文件夹内,并按上述操作步骤修改constants.py文件内的模型ID名字

本整合包只支持Windows电脑版,不支持其它系统使用,有感兴趣的可以自行下载体验

基于文档内容的聊天对话软件localGPT整合包下载:

相关推荐

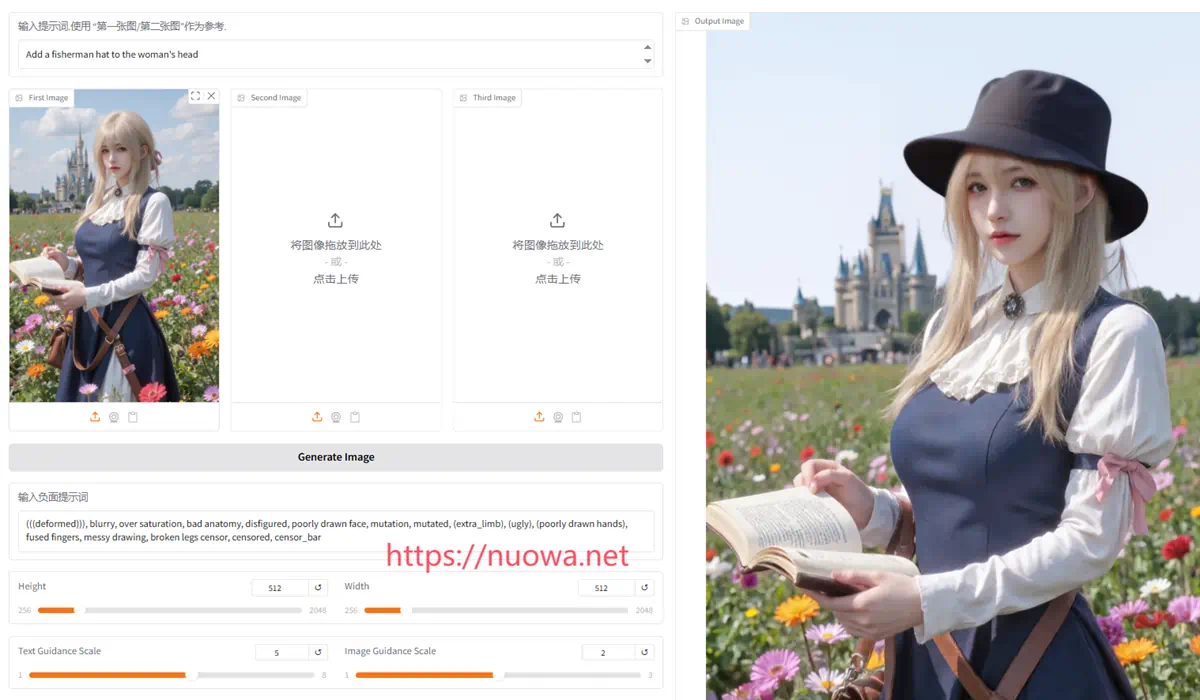

一句话编辑图片工具OmniGen2整合包下载,输入文本快速P图

一句话编辑图片工具OmniGen2整合包下载,输入文本快速P图 最新版PDF转Markdown格式软件MinerU一键启动整合包v0.10.0下载

最新版PDF转Markdown格式软件MinerU一键启动整合包v0.10.0下载 批量PDF文档转MD格式软件marker整合包下载,PDF文件转Markdown格式文件工具

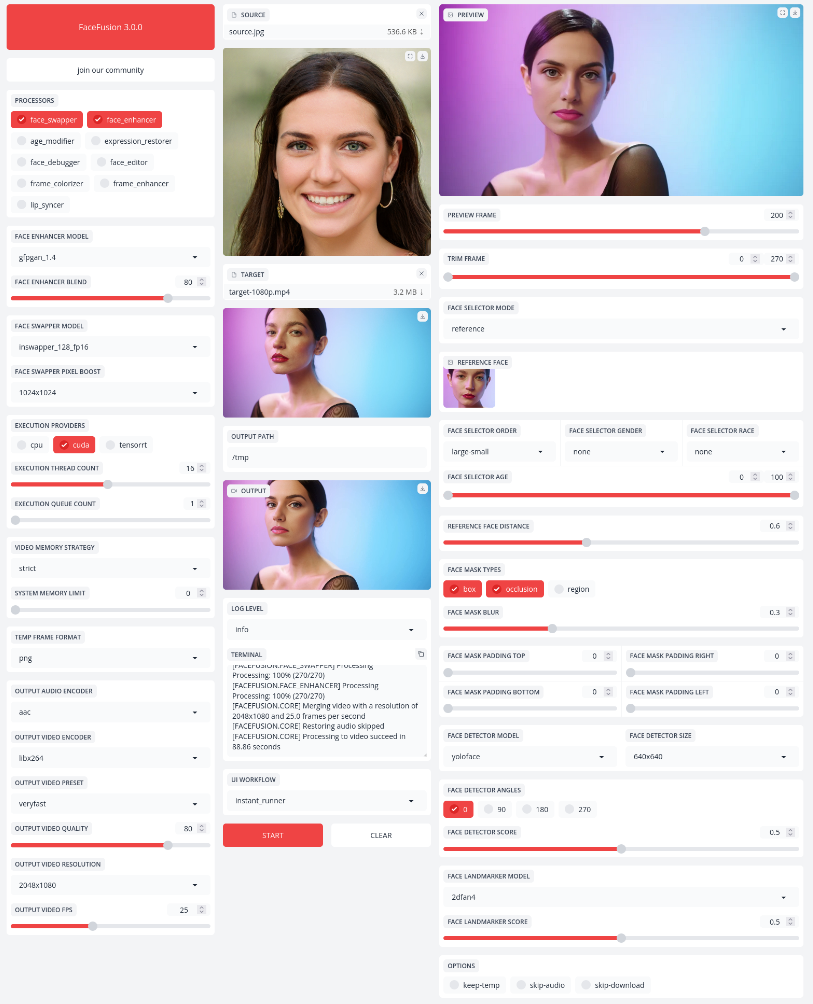

批量PDF文档转MD格式软件marker整合包下载,PDF文件转Markdown格式文件工具 人脸图片处理换脸软件facefusion整合包下载,改变年龄重建表情工具

人脸图片处理换脸软件facefusion整合包下载,改变年龄重建表情工具 免费文字转语音软件EmotiVoice整合包下载,TTS情感语音合成工具

免费文字转语音软件EmotiVoice整合包下载,TTS情感语音合成工具 2D图片转3D模型软件,AI建模工具Wonder3D整合包下载

2D图片转3D模型软件,AI建模工具Wonder3D整合包下载 音频驱动口型图片转视频软件hallo整合包免费下载,AI视频制作工具

音频驱动口型图片转视频软件hallo整合包免费下载,AI视频制作工具 全自动漫画图片翻译软件manga-image-translator整合包下载,日文漫画翻译中文神器

全自动漫画图片翻译软件manga-image-translator整合包下载,日文漫画翻译中文神器

最近更新

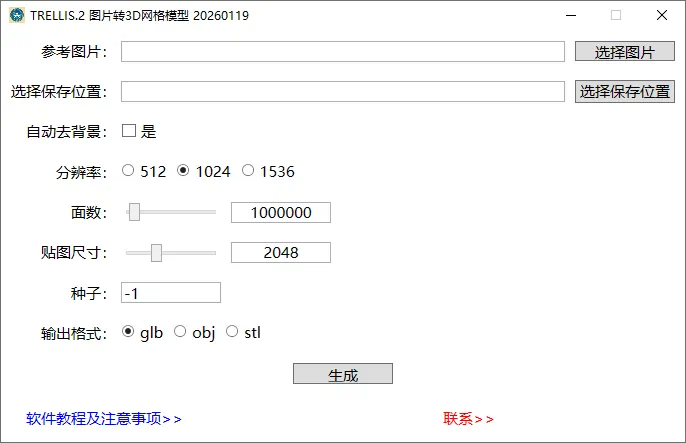

微软最新图片转3D网格模型软件TRELLIS.2 windows版整合包下载,AI一键建模工具

上个月微软发布了图片转3D网格模型软件TRELLIS的2.0版本。之前1.0版本非常受欢迎,当前2.0版本功能更强大,效果更好。我制作了最新windows版免安装一键启动整合包。 TRELLIS.2官方说明 TRELLIS.2 是一款最先进...

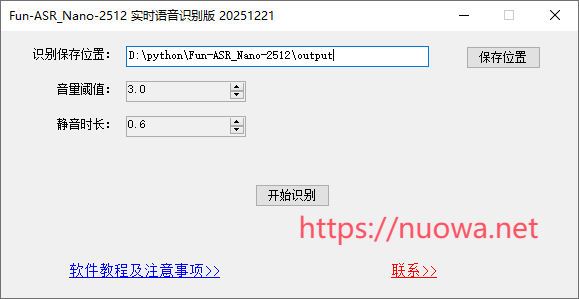

FunASR最新模型FunAudioLLM/Fun-ASR-Nano-2512实时语音识别转文字热词版整合包下载

Fun-ASR-Nano-2512是阿里通义实验室前天刚发布的最新最强的一款语音识别转文字模型,支持31种语言,延迟低,在某些专业领域表现出色。我基于FunAudioLLM/Fun-ASR-Nano-2512模型制作了最新实时语音识别转文字...

Nova数字人虚拟主播软件下载

这个还是2023年做的数字人项目,发现仍有人有这方面需求,我又重新做了一下。把其它所有功能都删除了,只保留了个音频文件驱动口型讲话的功能。 软件功能及用法 启动软件,点击右上角扳手按钮,打开设置界面,先选中一个主播人物,再选择导入一段音频文...

Crawl4AI:基于AI大语言模型的网络爬虫和数据抓取工具整合包软件下载

Crawl4AI是一款基于AI大语言模型能力的网络爬虫和数据抓取软件,可以将网页转换为简洁、符合 LLM 规范的 Markdown 格式,适用于 RAG、代理和数据管道。它速度快、可控性强。 Crawl4AI官方介绍 开源的 LLM 友好型...

browser-use浏览器任务全自动化AI助手windows电脑版一键启动整合包

本次再和大家分享一个非常牛逼的AI助手软件:browser-use,别问哪里牛逼,反正很多人都在用,社区starts高达72.8K,火遍全球的deepseek 100K,browser-use 72.8K,就问你火不火。之前我也分享过其它类...

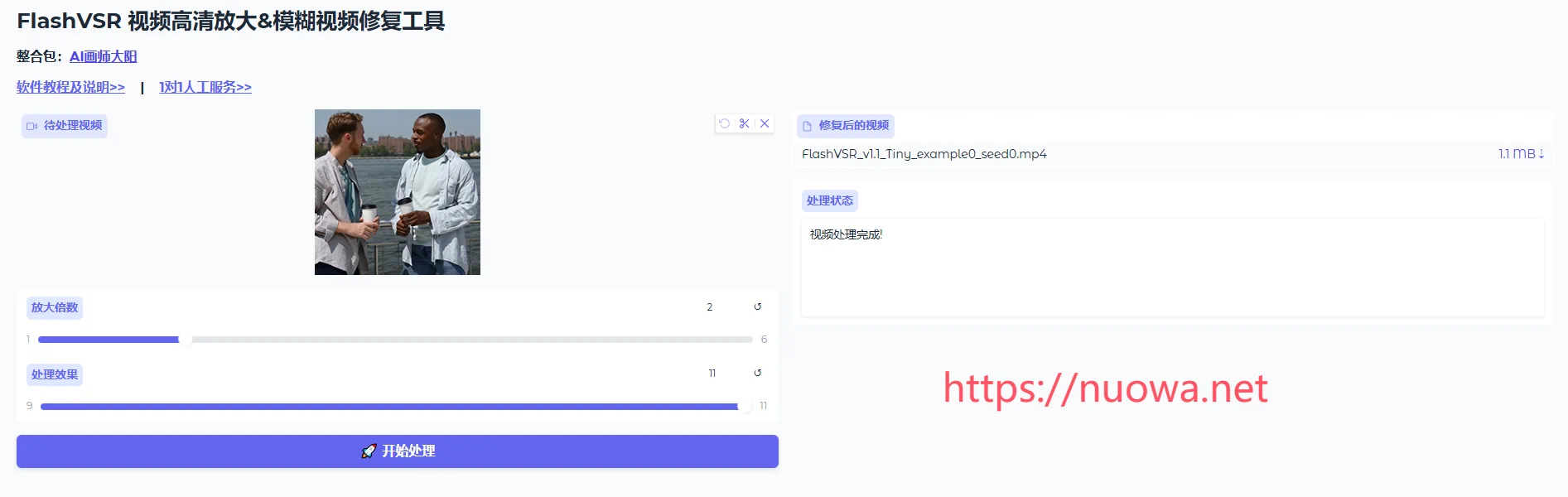

FlashVSR低分辨率模糊视频高清放大工具整合包v1.1下载,免安装一键启动

FlashVSR-一款高性能可靠的视频超高分辨率放大工具。迈向基于扩散的实时流式视频超分辨率——一种高效的单步扩散框架,用于具有局部约束稀疏注意力和小型条件解码器的流式VSR。 FlashVSR官方介绍 扩散模型最近在视频修复方面取得了进展...

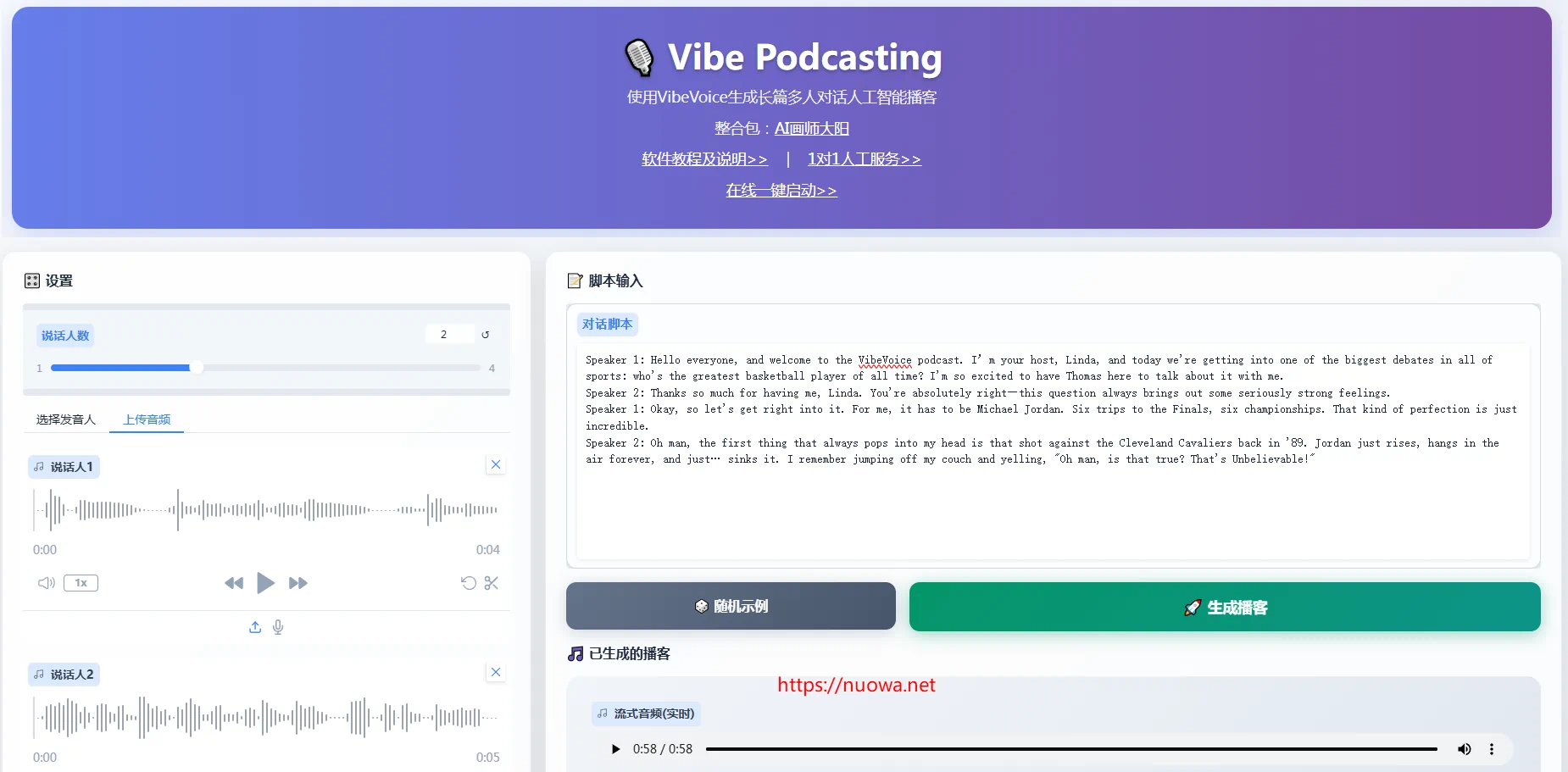

VibeVoice:富有表现力的长篇多人对话语音合成工具整合包下载

VibeVoice是微软开发的一款富有表现力的长篇多人对话语音合成工具。支持1-4个发音人,支持声音克隆自定义音色合成语音,我制作了最新的本地免安装一键启动整合包及云端在线版。 VibeVoice介绍 VibeVoice:一种前沿的长对话文...

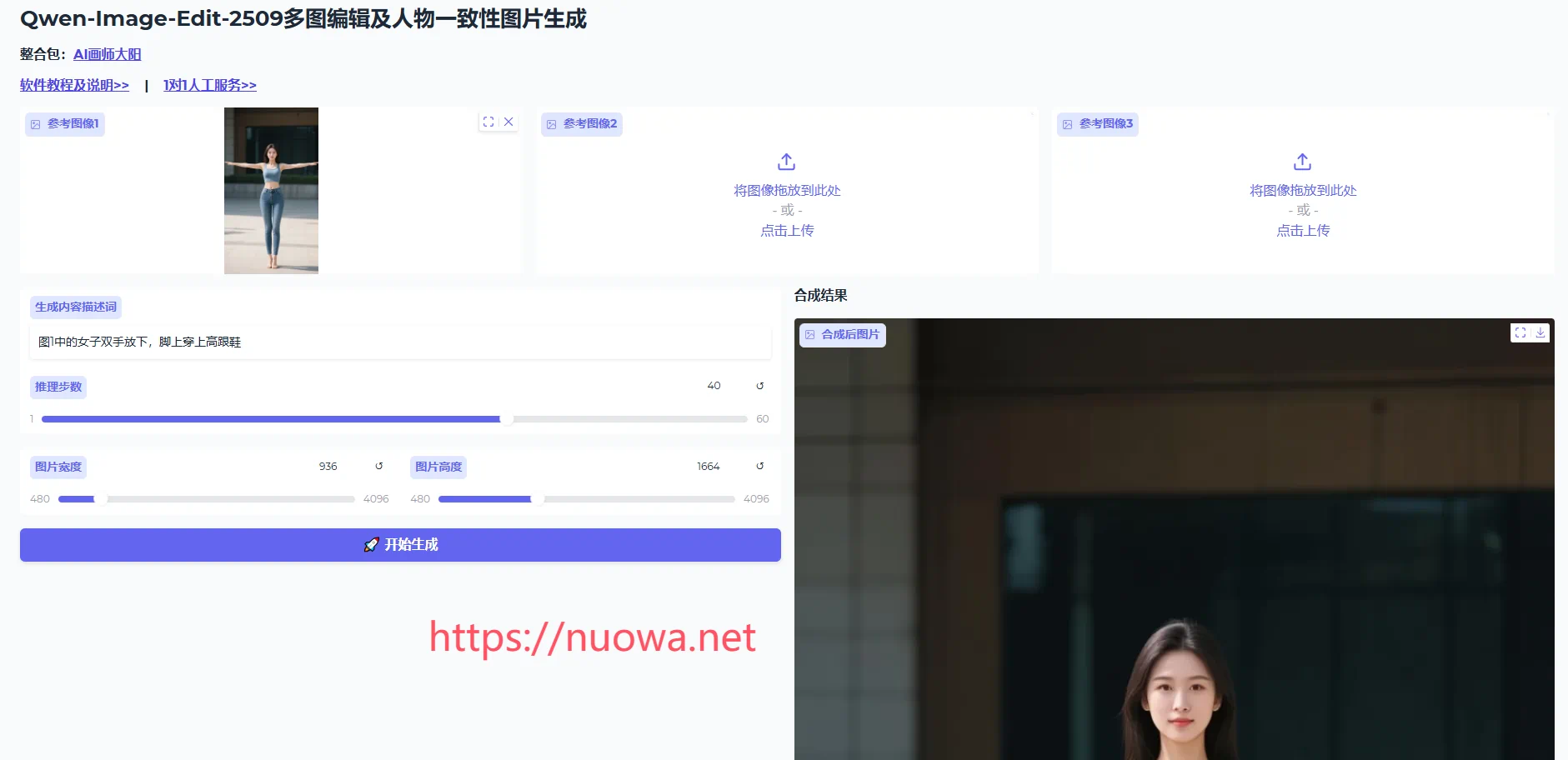

多图编辑人物一致性图片合成处理工具Qwen-Image-Edit-2509整合包下载,人物换装换姿势动作软件

Qwen-Image 是一个功能强大的图像生成基础模型,能够进行复杂的文本渲染和精确的图像编辑。Qwen-Image-Edit-2509是Qwen-Image-Edit的月度更新版本,增加了多图编辑和单图一致性生成功能。 Qwen-Imag...

摸鱼神器windows电脑隐藏任务栏软件图标工具rbtray下载

本次和大家分享一个摸鱼神器rbtray。 windows电脑软件运行的时候会在屏幕底部的任务栏上有一个软件图标,如果你开了哪个软件又不想被别人看到你正在运行这个软件的话,那么这个神器rbtray就非常适合你了。 rbtray可以快速将软件图...

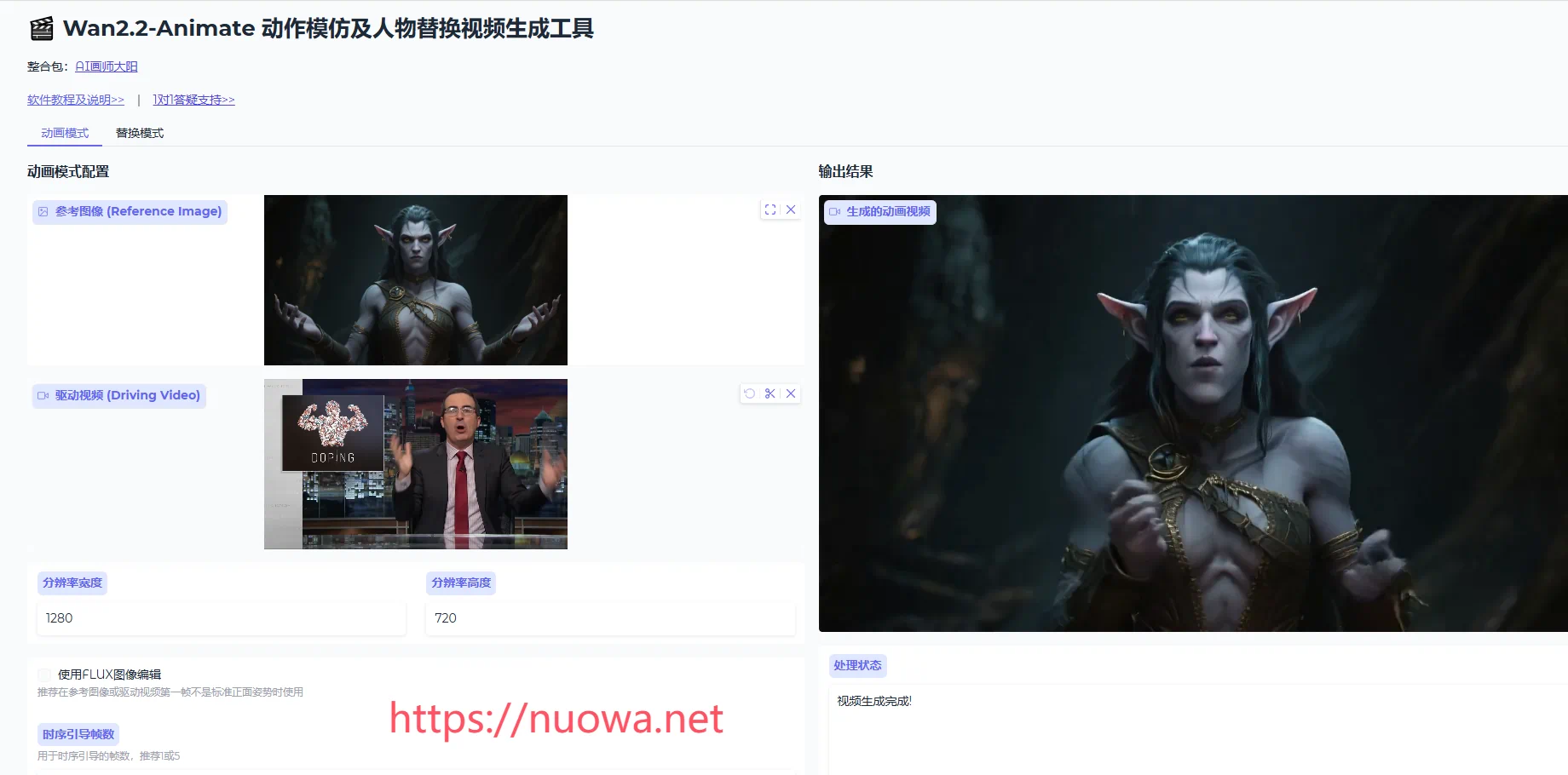

人物动作迁移及视频人物替换软件Wan2.2-Animate-14B整合包下载,动作模仿视频换主体工具在线一键启动

本次和大家分享一个非常强大的动作模仿及视频人物替换工具Wan2.2-Animate-14B,Wan-Animate接受一个视频和一个角色图像作为输入,并生成一个动作模仿或人物替换的视频,视频自然流畅,可玩性非常高。 Wan2.2-Anima...